法国人工智能初创公司 Mistral AI 推出了 Mixtral 8x22B,这是一种新的开源语言模型,该公司声称该模型实现了最高的开源性能和效率。

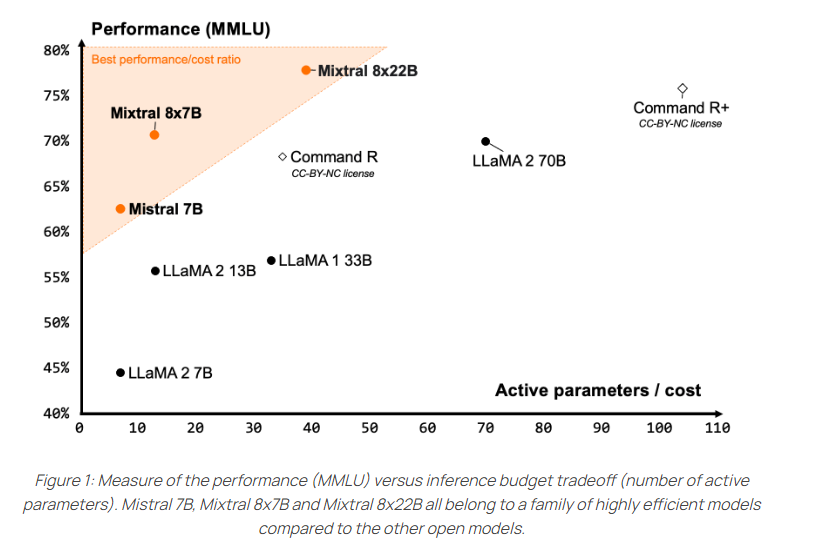

该模型是一个稀疏专家混合 (SMoE) 模型,仅主动使用 1,410 亿个参数中的 390 亿个参数。因此,开发团队声称,就其尺寸而言,它提供了非常好的性价比。其前身Mixtral 8x7B受到了开源社区的好评。

据 Mistral 介绍,Mixtral 8x22B 的优势包括多语言能力,支持英语、法语、意大利语、德语和西班牙语,以及强大的数学和编程能力。它还提供使用外部工具的本机函数调用。 64,000 个令牌的上下文窗口比当前领先的商业模型(例如GPT-4 (128K) 或Claude 3 (200K))的上下文窗口要小。

开源无限制

Mistral 团队在 Apache 2.0 许可证下发布 Mixtral 8x22B,这是目前最宽松的开源许可证。它允许不受限制地使用模型。

Mistral 表示,该模型对活动参数的稀疏使用使其比传统的密集训练的 700 亿个参数模型更快,并且比其他开源模型更强大。

与其他开放模型相比,Mixtral 8x22B 在 MMLU、HellaSwag、Wino Grande、Arc Challenge、TriviaQA 和 NaturalQS 等流行的理解力、逻辑和知识测试中取得了最佳成绩。

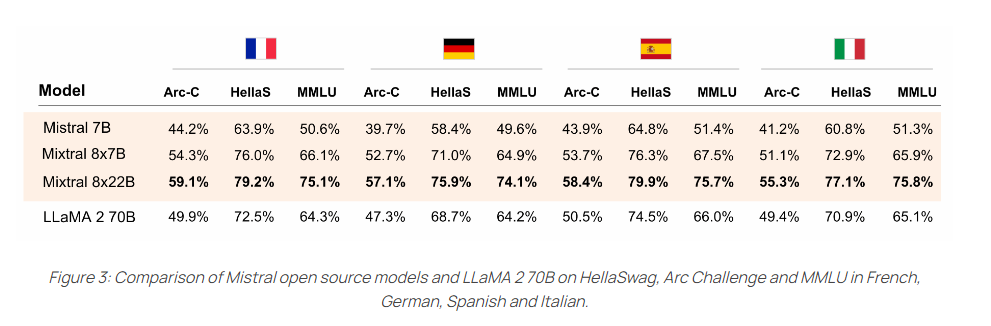

在 HellaSwag、Arc Challenge 和 MMLU 基准测试中,它在支持的语言(法语、德语、西班牙语和意大利语)中的表现也明显优于 70B LLaMA-2 模型。

与其他开放模型相比,Mixtral 8x22B 在 MMLU、HellaSwag、Wino Grande、Arc Challenge、TriviaQA 和 NaturalQS 等流行的理解力、逻辑和知识测试中取得了最佳成绩。

在 HellaSwag、Arc Challenge 和 MMLU 基准测试中,它在支持的语言(法语、德语、西班牙语和意大利语)中的表现也明显优于 70B LLaMA-2 模型。

新模型现在可以在 Mistral 的“la Platforme”上进行测试。 Mistral 表示,开源版本可在 Hugging Face 上找到,并且是微调应用程序的一个很好的起点。该模型需要 258 GB 的 VRAM。

发表评论

您还未登录,请先登录。

登录